¡Hola! Soy Gonzalo, Analista de Datos de Argentina, con formación como Técnico Superior en Ciencia de Datos y actualmente estudiante de la Licenciatura en Ciencia de Datos en la Universidad del Gran Rosario. Me apasiona convertir datos en conocimiento útil y continúo aprendiendo y perfeccionando mis habilidades en análisis, modelado y visualización, junto con un fuerte interés en la ingeniería de datos y el desarrollo y puesta en producción de modelos predictivos.

Como Analista de Datos, ayudo a las empresas a optimizar sus operaciones y a tomar decisiones informadas mediante reportes y análisis. Mi experiencia incluye trabajar con datos de diversas fuentes, aplicando técnicas de limpieza, transformación y visualización para generar insights claros y accionables.

Estoy orientando mi perfil profesional hacia el rol de Analytics Engineer. En esta función, no solo analizo datos, sino que transformo y preparo conjuntos de datos limpios y confiables, aplicando buenas prácticas de ingeniería como control de versiones, testing automatizado y documentación clara, para que otros usuarios puedan responder sus propias preguntas con confianza.

Además, me estoy desarrollando en el campo de Machine Learning Engineering, enfocándome en el diseño, entrenamiento y despliegue de modelos predictivos escalables, con el objetivo de llevar las soluciones de IA desde la experimentación hasta entornos productivos.

Mi objetivo profesional es seguir creciendo como un perfil híbrido de datos capaz de conectar la analítica, el software y la infraestructura para construir soluciones eficientes, reproducibles y orientadas al impacto real en el negocio.Te invito a explorar mi repositorio donde comparto mis proyectos. Si compartimos intereses o quieres hablar sobre datos, no dudes en conectarte conmigo. ¡Será un placer conversar!

Formación orientada al análisis estadístico, procesamiento de datos, desarrollo de modelos de machine learning y deep learning, con aplicaciones en visión por computadora, procesamiento de lenguaje natural y sistemas predictivos. Incluye conocimientos sólidos en programación (Python, R, SQL), bases de datos, matemáticas, estadística y ética en la inteligencia artificial.

Durante la carrera se adquieren competencias para liderar proyectos de ciencia de datos, diseñar soluciones basadas en IA, y comunicar resultados de forma clara y efectiva. Se trabajan herramientas como pandas, NumPy, scikit-learn, redes neuronales y técnicas de Big Data, aplicadas en contextos reales a través de prácticas profesionalizantes.

La Licenciatura en Ciencia de Datos de la Universidad del Gran Rosario ofrece una formación sólida en estadística aplicada, ingeniería de software, aprendizaje automático, aprendizaje profundo, procesamiento de lenguaje natural y visión por computadora. A lo largo del plan de estudios se abordan herramientas de software para análisis de datos, metodologías de investigación y desarrollo de proyectos tecnológicos orientados a problemas reales.

El perfil del egresado está orientado a la aplicación práctica de técnicas avanzadas de ciencia de datos para resolver desafíos complejos en diversos sectores. Se adquieren competencias para:

Este repositorio está pensado para demostrar no solo habilidades técnicas, sino también una visión integral del ciclo de vida del dato, desde la extracción y transformación hasta su análisis, visualización y presentación a usuarios finales o despliegue en entornos reales.

El objetivo de este proyecto es analizar y visualizar la fase ofensiva del Manchester City durante la temporada 2023/2024 en la Premier League, con un enfoque especial en los pases y tiros. Para realizar este análisis, se extrajeron datos mediante scraping de una página web de estadísticas de fútbol utilizando Python, y luego fueron transformados para su visualización en Power BI.

Una empresa de retail nacional, líder en la venta de productos electrónicos, ha decidido expandirse a nuevos mercados regionales. Actualmente opera en cinco ciudades principales y desea extender su presencia a tres nuevas ciudades donde aún no tiene operaciones. La dirección necesita una estrategia basada en datos para maximizar la rentabilidad y minimizar los riesgos asociados con esta expansión.

Este proyecto implementa un pipeline híbrido de detección y OCR para identificar, validar y hacer seguimiento de códigos ISO 6346 en contenedores marítimos. Combina modelos YOLOv8 para detección de regiones y caracteres con EasyOCR como método de respaldo y métodos de validación

La certificación en análisis de datos de Google cubre los conceptos fundamentales del análisis de datos, incluyendo herramientas y técnicas para transformar datos en insights significativos. Está orientada a principiantes y proporciona habilidades prácticas aplicables en el mundo real.

La certificación en Análisis de Datos con Microsoft Power BI está diseñada para capacitar a los estudiantes en el uso de Power BI como herramienta para transformar datos en insights significativos. Se enfoca en el manejo de datos, la visualización y la creación de informes interactivos.

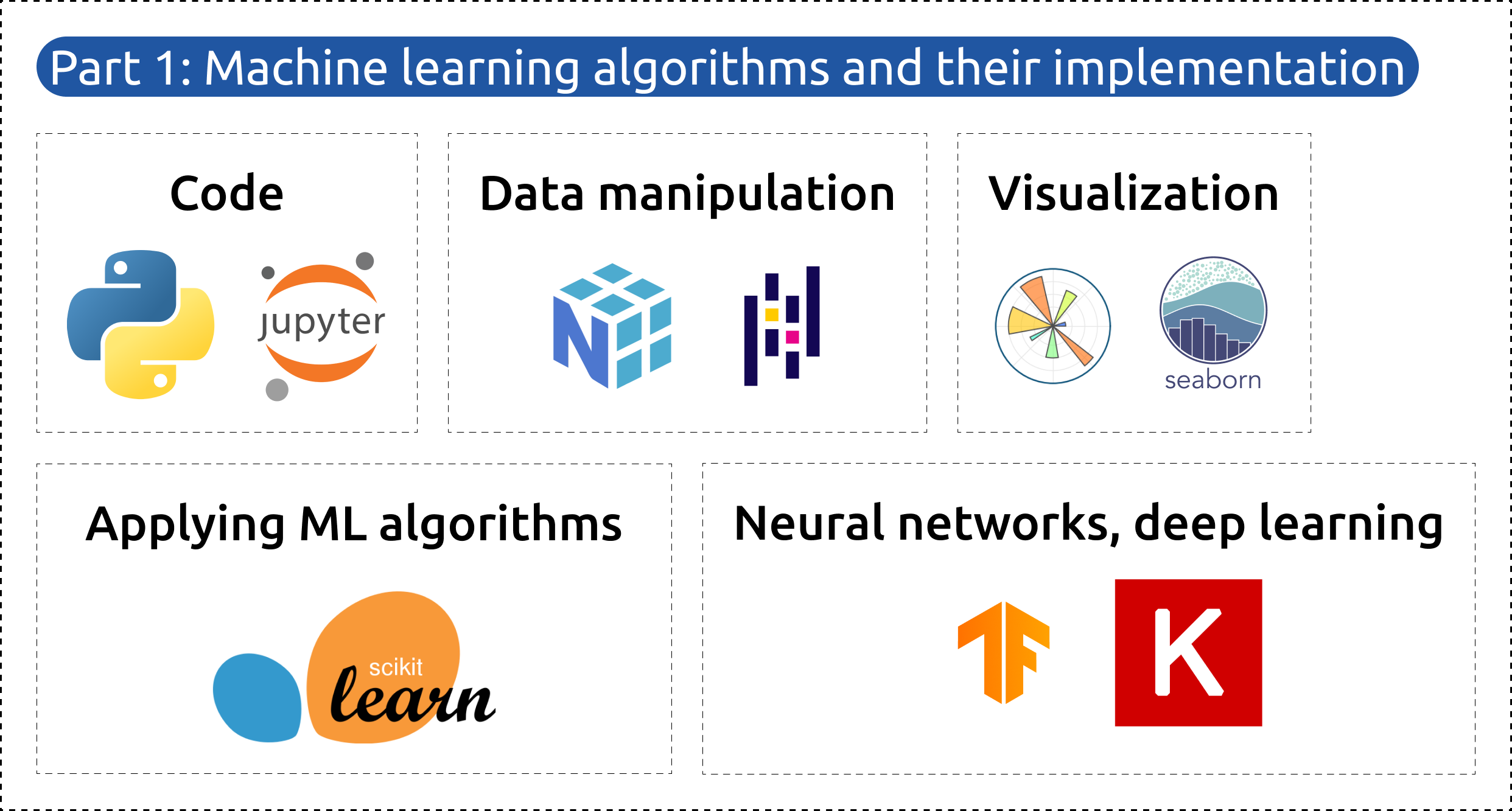

La Parte 1 se centra en los principales algoritmos de aprendizaje automático y su aplicación práctica utilizando Python. Los temas tratados incluyen:

La Parte 2 está dedicada al despliegue de modelos, que implica poner modelos de aprendizaje automático en producción. En esta sección, adquirirás habilidades prácticas utilizando marcos y herramientas populares. Los temas tratados incluyen: